别数告高效拥抱潭,据分据泥析新T数思路

作为一名在区块链领域摸爬滚打多年的老手,我深知NFT数据分析的水有多深。每当看到新手开发者一头扎进这个领域时,总会想起自己当年的狼狈模样——面对海量数据手足无措,整夜整夜地写爬虫脚本,到头来数据还没收集完,市场行情早就变了天。

数据分析的五大痛点

说实话,做NFT数据分析就像在玩一场永远打不完的地鼠游戏。首先是数据来源,以太坊、Solana、Polygon...每条链的数据格式都不一样。记得去年我帮一个客户分析Bored Ape的数据,光是清理数据就花了整整两个礼拜。

其次是数据时效性这个老大难问题。上周刚分析完一个蓝筹项目的持有者分布,结果昨天突然有个鲸鱼地址转手了200个NFT,所有结论都得推倒重来。更别提那些让人头大的隐私合规问题了,稍不注意就可能踩雷。

我的数据救赎之路

直到去年偶然接触到NFTScan的API,我才真正从数据泥潭中爬出来。他们的数据覆盖之广让我印象深刻——18条主流公链,50多个专业接口,连冷门的Aptos链都支持。最让我惊喜的是他们的数据更新速度,基本上链上交易确认后1分钟内就能查到。

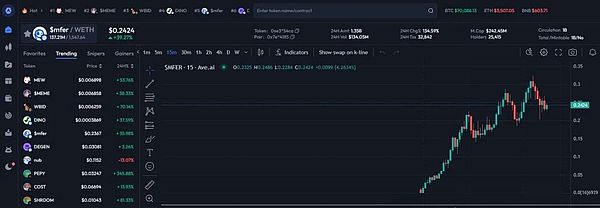

记得有次凌晨三点赶项目,需要分析最近24小时的NFT交易热点。要是以前,我可能得开着5台服务器跑整晚。但用NFTScan的Trade Ranking接口,5行Python代码就搞定了。当时看着返回的数据,真有种"早知道有这个就好了"的感慨。

实战经验分享

以分析巨鲸钱包为例,传统做法要监控成千上万个地址的交易记录。现在用他们的Wallet Ranking接口,直接就能拿到持仓排名前1000的地址数据。我特别喜欢他们的holding_volume参数,能快速判断哪些鲸鱼在囤货,哪些在出货。

给个实用小技巧:如果你在做NFT市场监控,可以先调用Marketplace Ranking接口,用volume_change参数筛选出增长最快的交易平台。上周我就靠这个方法,提前发现了Blur平台上的流动性异动。

开发建议

对于刚入门的开发者,我建议先从Collection Overview接口入手。它就像一个NFT项目的体检报告,从地板价到持有分布应有尽有。调用方法也简单,Python示例如下:

import requestsurl = "https://api.nftscan.com/v2/statistics/collection"headers = { "X-API-KEY": "你的API_KEY"}params = { "contract_address": "0xbc4...f13d"}response = requests.get(url, headers=headers, params=params)print(response.json())

记住要善用他们的1M免费调用额度,足够支撑中小型项目的前期开发。如果遇到技术问题,他们的开发者社区响应速度很快,我上次提的问题2小时就得到解答了。

行业观察

从去年开始,明显感觉到NFT数据服务正在向专业化发展。像NFTScan这样的平台,正在改变这个领域的游戏规则。他们最新推出的Gas Ranking接口,连矿工的交易策略都能分析出来,这在以前想都不敢想。

展望未来,随着NFTFi的兴起,对链上数据分析的需求只会越来越强。与其自己造轮子,不如站在专业数据服务商的肩膀上。毕竟在这个行业,快人一步看到数据趋势,往往就意味着真金白银的收益。

加密天下

加密天下